AIセキュリティ投資の奇妙な一致:「信頼運用(TrustOps)」層の誕生

直近1年のAIセキュリティ分野における資金の流れを追っていると、少し奇妙な感覚が残ります。例えば、AIが生み出す巧妙なソーシャルエンジニアリング攻撃から「人」を守るAdaptive Securityには、OpenAIのファンドも参加する形で大型の投資が行われました。

一方で、AIモデルそのものの安全性をリリース前に評価するIrregularには8,000万ドルもの資金が集まり、従業員がAIに機密情報を漏洩させてしまう「データ」のリスクを防ぐCyberhavenは、約1億ドルの調達でユニコーン企業へと到達しています。

これだけではありません。AIシステム同士が連携する際に使われる「機械」のIDを保護するToken Securityにも2,000万ドルが集まり、AIが稼働する基盤である「クラウド」の安全性を高めるUpwindは、シリーズAで1億ドルを調達しました。

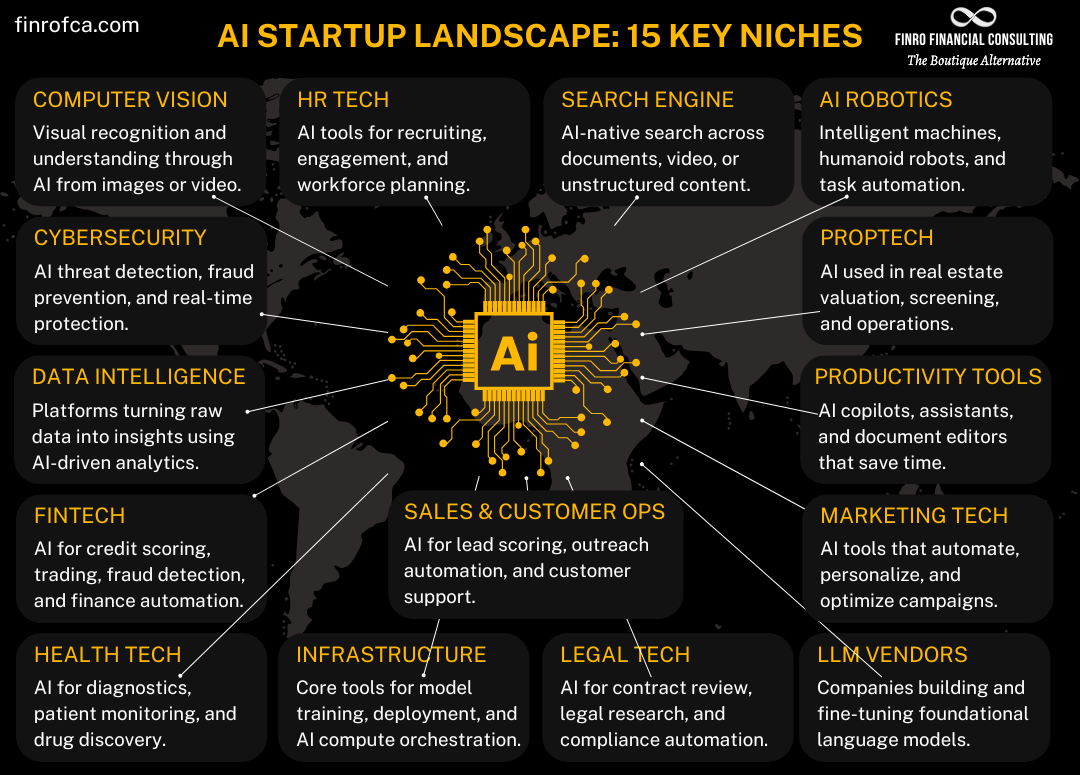

どうやら、投資家の資金は人、データ、機械、モデル、クラウドという5つの領域に、まるで示し合わせたかのように同時多発的に集まっているようです。これは単なる偶然なのでしょうか。私には、AIセキュリティがもはや単一の技術カテゴリではなく、AIの信頼性を運用レベルで担保するための新たな「信頼運用(TrustOps)」層として立ち上がってきている、そんな気がしてなりません。

市場予測の矛盾が示す本質

この新しい動きを理解しようとすると、まず市場規模の予測データが大きな壁として立ちはだかります。ある調査では、AIを活用したサイバーセキュリティ市場は2032年までに約2,346億ドル(年平均成長率31.7%)に達するという非常に強気なシナリオが示されています。しかし、別の調査では同じ2032年の市場規模を約1,667億ドル(年平均成長率12.5%)とする、より抑制的な推計も存在します。

この大きな差は、単に「何をAIセキュリティと定義するか」という範囲の違いだけでは説明しきれないように思います。むしろこの矛盾こそが、市場の本質を捉える鍵ではないでしょうか。

例えば、Palo Alto Networksのような大手セキュリティ企業は、自社のクラウドセキュリティプラットフォームにAIネイティブな保護機能を統合し始めています。こうなると、セキュリティの売上は単体の製品としてではなく、プラットフォーム全体の機能の一部として計上されるため、市場規模の測定はより複雑になります。

つまり、市場規模の絶対値を追いかけることよりも、投資家がどのような「パターン」で資金を投じているのかを読み解くことのほうが、はるかに重要だと考えられます。そしてそのパターンが指し示しているのは、前述した5つの領域が相互に連携し、AIシステム全体の信頼を支える一つの層を形成しつつあるという現実です。

「信頼運用(TrustOps)」層の誕生

」層の誕生-1-1024x804.png)

生成AIの普及は、攻撃の質と量を同時に引き上げました。それに対抗するためには、モデルを開発する側(上から)の安全対策と、AIを現場で利用する側(下から)の運用対策の両方が不可欠です。

- 人を鍛える(例:Adaptive Security)

- データを漏らさない(例:Cyberhaven)

- 機械の身元を管理する(例:Token Security)

- モデルを評価し、監視する(例:Irregular、Mindgard)

- クラウドの実行環境を守る(例:Upwind)

これらのピースが組み合わさることで、初めてAIをビジネスに組み込むための「信頼の基盤」が生まれます。この一連の活動こそが、私が「信頼運用(TrustOps)」と呼びたい新しい概念です。このTrustOps層は、企業のコンプライアンスや監査、そして顧客からの信頼を得るための「通行証」のような役割を担い始めているのではないでしょうか。

この記事では、まさに生まれつつある「TrustOps」という新しい市場の姿を、直近1年の資金調達動向から解き明かしていきます。次のセクションでは、資本が集中する5つの具体的な戦線と、そこで活躍する主要なスタートアップたちの動きを詳しく見ていくことにしましょう。

資本が集中する5つの戦線:最新ディールから読み解くAI防衛のホットスポット

前のセクションで、AIセキュリティへの投資が「人・データ・機械・モデル・クラウド」という5つの領域に同時集中し、新たな「信頼運用(TrustOps)」層を形成しつつあるのではないか、という仮説を提示しました。では、具体的にそれぞれの戦線ではどのような戦いが繰り広げられ、スマートマネーはどこに流れ込んでいるのでしょうか。

ここからは、過去1年ほどの大型資金調達の事例を紐解きながら、AI防衛の最前線となっている5つのホットスポットを具体的に見ていきたいと思います。

人間中心の防御:最大の脆弱性は「人」であるという原点回帰

生成AIがもたらした最も大きな変化の一つは、ソーシャルエンジニアリング攻撃の質と量が劇的に向上したことでしょう。CrowdStrikeのレポートによれば、AIで生成されたフィッシングメールは、人間が書いたものよりもクリック率が4.5倍も高いという調査結果も出ています。どうやら、技術的な防御だけでは限界で、最終的な意思決定者である「人間」を守ることが、最も重要な防衛線になっているようです。

この領域で象徴的な動きを見せたのがAdaptive Securityです。同社は、AIが生成したディープフェイク音声や偽のメッセージを使った攻撃をシミュレーションし、従業員を訓練するプラットフォームを提供しています。注目すべきは、OpenAIのスタートアップファンドが同社に出資している点です。報道によって金額に幅はありますが(4,300万ドルから総額5,500万ドル)、AI技術を提供する側が、その悪用リスクから人間を守る技術にも資本を投じ始めたという事実は、非常に大きな意味を持つのではないでしょうか。

また、ディープフェイク検出そのものに特化したGetRealは、シリーズAで1,750万ドルを調達しました。投資家にはCisco Investmentsや、CIAと関係の深いIn-Q-Telといった戦略的プレイヤーが名を連ねており、この技術が金融や政府機関といった高い信頼性が求められる領域で喫緊の課題となっていることを示唆しています。

AI向けデータ漏洩防止(DLP):意図せぬ情報流出を食い止める

従業員が日々の業務でChatGPTのような外部AIツールを利用する際、悪意なく機密情報を入力してしまうリスクは、多くの企業にとって頭の痛い問題です。この「AI時代のデータ漏洩防止(DLP)」という領域で、圧倒的な存在感を示しているのがCyberhavenです。

同社は、従業員のデータ操作の文脈をAIで解析し、機密データが外部のAIサービスに送信されるといった異常な動きを検知するソリューションを提供しています。そして2025年4月、新たに約1億ドルの資金調達を発表し、ユニコーン企業の仲間入りを果たしました。MotorolaやOscar Healthといった大企業を顧客に抱え、年間経常収益(ARR)は5,000万ドルを超えると予測されています。この力強い成長は、多くの企業にとってAI向けDLPが「あれば良い」ものではなく、「今すぐ必要な」対策であることを物語っているように思います。

機械ID保護:ハッカーは「ログイン」してくる

クラウド化と自動化が進んだ結果、私たちのシステム内では人間だけでなく、無数の「機械」が自律的に活動しています。APIキーやサービスアカウントといった「機械ID」は、今やハッカーにとって格好の標的です。

この新たな攻撃対象に特化しているのがToken Securityです。同社は、企業内に存在する無数の機械IDを自動的に発見し、リスクを可視化するプラットフォームを開発。シリーズAラウンドで2,000万ドルを調達しました。このラウンドにPalo Alto NetworksやCrowdStrikeの幹部が個人として参加している点は興味深い事実です。盗まれた認証情報でAIサービスを不正利用する「LLMJacking」のような攻撃は、セキュリティリスクだけでなく、想定外の高額なクラウド請求を引き起こす可能性もあります。機械IDの保護は、CISO(最高情報セキュリティ責任者)だけでなく、CFO(最高財務責任者)にとっても見過ごせないテーマになっているのではないでしょうか。

モデルの事前評価とランタイム防御:AIそのものを守る

AIシステムの中核であるモデルそのものの脆弱性や、予期せぬ挙動をいかにコントロールするか。これは、AIセキュリティにおける最も根源的な課題の一つです。この領域では、モデルをリリースする「前」の評価と、稼働させた「後」の監視という、二つのアプローチに資本が集中しています。

前者、つまり事前評価の領域で大きな注目を集めているのがIrregularです。同社は、フロンティアAIモデルが危険な能力を持っていないかをリリース前にテスト・評価するプラットフォームを開発し、8,000万ドルという大規模な資金調達に成功しました。

後者、つまりランタイム(実行時)の防御では、AIアプリケーション固有の脆弱性を狙うNoma Security(シリーズAで2,500万ドル調達)や、AIに対する動的なセキュリティテスト(DAST-AI)を提供するMindgard(800万ドル調達)といったスタートアップが登場しています。どうやら、モデルの安全性は「出荷して終わり」ではなく、継続的に監視・評価していく運用が不可欠だという認識が広まっているようです。

クラウドネイティブ保護:AIが動く土台を固める

AIワークロードの多くがクラウド上で実行される現代において、その稼働基盤であるクラウド環境のセキュリティは言うまでもなく重要です。しかし、従来のクラウドセキュリティツールは膨大なアラートを生成し、セキュリティチームを疲弊させるという課題を抱えていました。

この問題に対し、ランタイムの脅威に焦点を当て、本当に重要なアラートだけを提示することで「アラートを90%削減する」という価値を打ち出したのがUpwindです。同社はこの明確な価値提案で、シリーズAにおいて1億ドルという巨額の資金調達を達成しました。AI時代においては、脅威を検知する能力だけでなく、セキュリティ運用の効率をいかに高めるかという点も、投資家から高く評価されるポイントになっていると考えられます。

これら5つの戦線で起きていることは、個別の技術トレンドというよりも、AIという新しいテクノロジーを社会に実装するための「ガードレール」が、猛スピードで建設されている様子そのものだと言えるでしょう。

では、なぜOpenAIやSequoia Capitalのような業界のトッププレイヤーたちが、これほどまでに「防御」の領域に賭けているのでしょうか。次のセクションでは、彼らの戦略的な意図をさらに深く読み解いていきます。

ゲームのルールを変える戦略投資家:OpenAIやSequoiaはなぜ「防御」に賭けるのか?

前のセクションでは、AIセキュリティへの投資が5つの主要な戦線で活発化している様子を見てきました。一見すると、これらの投資は個別の脅威に対応する「点」の動きに見えるかもしれません。しかし、その背後にいるプレイヤー、特にOpenAIやSequoia Capitalといった業界の巨人の動きを深掘りすると、どうやらもっと大きなゲームが動いている気がしてきます。

彼らの投資は、単なる財務リターンを狙ったものではないように思うのです。むしろ、AIという新しい大陸のルールそのものを定義し、エコシステム全体の未来を形作ろうとする、極めて戦略的な一手ではないでしょうか。

エコシステムの「信頼」に賭けるOpenAI

象徴的なのは、OpenAIによるAdaptive Securityへの投資です。これはOpenAIにとって初のサイバーセキュリティ分野への投資であり、報道によって金額に幅はありますが、シリーズAラウンドで4,300万ドルを共同主導し、最終的に総額5,500万ドルに達したと報じられています。

なぜ、生成AIのトップランナーであるOpenAIが、ディープフェイクを使った攻撃シミュレーションと従業員訓練という「人間中心の防御」に特化する企業に資本を入れたのでしょうか。

これは、彼らがAI技術の普及における最大の障壁が、技術そのものではなく「社会からの信頼」にあると理解しているからではないかと、私は考えています。生成AIがもたらすディープフェイクや高度なフィッシングといった負の側面は、技術の社会実装に対するブレーキになりかねません。OpenAIは、そのブレーキを自らアクセルに変えるため、防御インフラの構築に直接関与することを選んだのではないでしょうか。

OpenAI Startup Fundのパートナーは、Adaptive Securityを「AIネイティブな防御を構築している」と評価しています。これは、AIが生み出す脅威には、AIでしか対抗できないという認識の表れです。自分たちの技術がもたらすリスクを誰よりも深く理解しているからこそ、その対策に最も効果的な投資ができる。OpenAIの動きは、AIプラットフォーマーがエコシステム全体の健全性に責任を持つという、新しい時代の幕開けを告げているのかもしれません。

市場の「ものさし」を創るSequoia Capital

一方で、トップVCであるSequoia Capitalの動きは、また違った角度から市場のルール形成を狙っているように見えます。彼らがリードし、8,000万ドルという大規模な資金調達を成功させたIrregularは、フロンティアAIモデルの安全性をリリース前に評価する企業です。

Sequoiaのウェブサイトには「Partnering with Irregular: Ahead of the Curve」という記事が堂々と掲載されており、このパートナーシップが戦略的に重要であることがうかがえます。

私が特に注目しているのは、Irregularが開発し、提唱している「SOLVE」という評価フレームワークです。これは、AIモデルがサイバーセキュリティの課題を解決する能力を定量的にスコアリングするオープンスタンダードです。実際に、このフレームワークはOpenAIやAnthropicといったトッププレイヤーのモデル評価にも利用され始めています。

どうやらSequoiaは、単一のセキュリティ技術に投資しているだけではないようです。彼らが賭けているのは、AIモデルの安全性を測る「ものさし」そのものではないでしょうか。ある市場において「標準」や「評価基準」を確立することは、その市場における絶大な影響力を手に入れることを意味します。どのモデルが安全で、どのモデルが危険かを判断する基準を握ることは、AI市場のゲームのルールを定義することに他なりません。

さらに興味深いのは、Sequoiaが自律型エージェントの開発を手がけるReflection AIのような企業にも投資している点です。彼らはAIの性能向上(アクセル)と安全性確保(ブレーキ)の両方に賭けることで、AIの進化の方向性そのものをコントロールしようとしているのかもしれません。

OpenAIやSequoiaの動きから見えてくるのは、AIセキュリティがもはや単なるコストやリスク対策ではなく、AIエコシステム全体の成長を左右する「戦略的投資領域」へと昇華したという事実です。彼らが築こうとしているのは、個別のツール群ではなく、信頼できるAIが社会に実装されるための基盤、いわば「信頼のOS」のようなものだと考えられませんか?

では、この大きなゲームルールの変化の中で、私たち自身は具体的にどのような一手を打つべきなのでしょうか。次のセクションでは、日々の業務に落とし込める実践的なプレイブックを考えていきたいと思います。

「TrustOps」時代を乗りこなす具体策

これまでのセクションで、私たちはAIセキュリティ市場で起きている地殻変動を追いかけてきました。人、データ、機械、モデル、クラウドという5つの戦線に同時多発的に資本が流れ込み、どうやら「信頼を運用する(TrustOps)」という新しい層が生まれつつあること。そして、その背後でOpenAIやSequoia Capitalといった巨人たちが、単なるリターン以上の、市場のルールそのものを形作ろうとしていることを見てきました。

分析は面白いものですが、それだけでは日々の仕事は1ミリも進みません。では、この大きなうねりの中で、私たちは明日から具体的に何をすればよいのでしょうか。

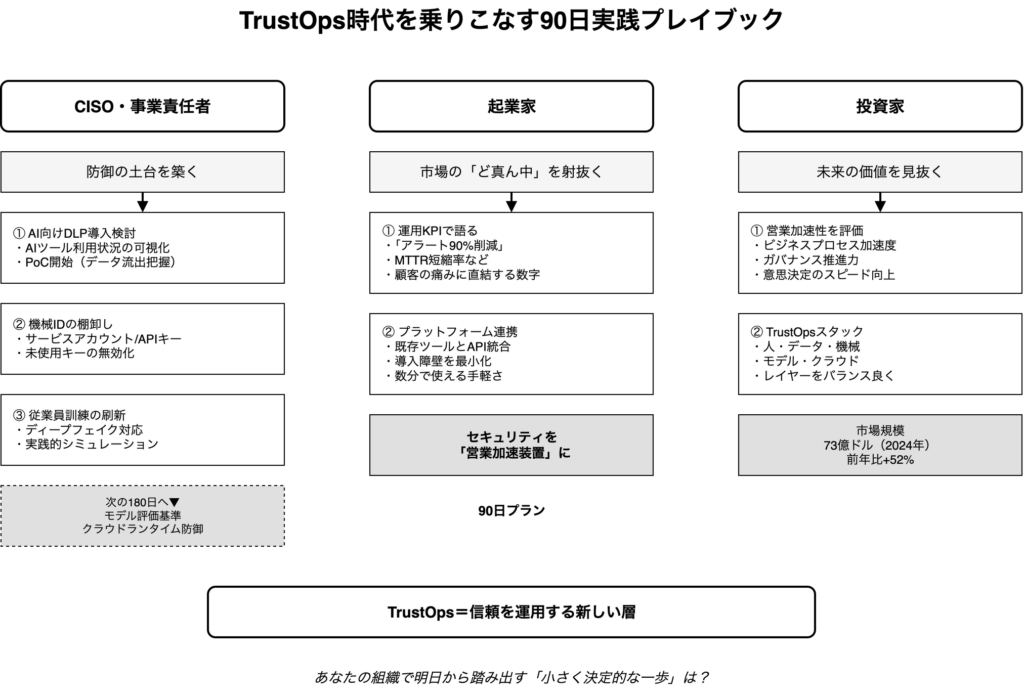

この最後のセクションでは、これまでの分析を具体的なアクションプラン、いわば「実践的プレイブック」に落とし込んでみたいと思います。CISOや事業責任者、新たな事業を企てる起業家、そして未来に賭ける投資家、それぞれの立場から、次の90日、180日で打つべき手を考えていきましょう。

CISO・事業責任者向け:防御の土台を築く90日プラン

AIの導入が現場で加速する中、セキュリティ部門には待ったなしの対応が求められています。しかし、すべてを一度にやろうとすると必ず失敗します。まずは防御の土台を固めるための、最初の90日に集中してみてはどうでしょうか。

AI向けデータ漏洩防止(DLP)の導入検討

従業員がChatGPTのような外部AIに、悪気なく機密情報を入力してしまう。これは、今そこにある最も現実的なリスクの一つです。この課題に取り組むCyberhavenが約1億ドルを調達し、ユニコーン企業となったという事実は、市場がいかにこの問題を深刻に捉えているかを物語っています。

最初の一歩として、まずは自社でどのようなAIツールが、どの部署で、どのように使われているかを可視化することから始めてはどうでしょうか。その上で、AI向けのDLPソリューションの概念実証(PoC)を開始し、どのデータが、どこへ流れ出しているのかを把握することが重要だと思います。

「機械ID」の棚卸し

クラウド化や自動化が進むにつれ、人間ではない「機械」が持つID(サービスアカウントやAPIトークン)が爆発的に増えています。そして、ハッカーたちはこの「見えないID」を新たな侵入口として狙い始めています。この領域に特化するToken Securityが2,000万ドルを調達したことは、問題の深刻さを示唆しています。

最初の90日で、まずは社内に存在するサービスアカウントやAPIキーを棚卸し、誰が・何が・どの権限で動いているのかをリストアップすることから着手すべきです。使われていない古いキーを無効化するだけでも、攻撃対象領域を大きく減らすことができるはずです。

現実的な従業員訓練の開始

生成AIによって作られるフィッシングメールは、人間が書いたものよりクリック率が4.5倍も高いという調査結果もあります。従来の「怪しいメールは開かないように」という訓練だけでは、もはや不十分かもしれません。

Adaptive SecurityがOpenAIの支援を受けて提供するような、ディープフェイク音声や映像を実際に使ったシミュレーション訓練は、従業員の免疫力を高める上で効果的だと考えられます。まずはパイロットプログラムとして、特定の部署で試してみてはどうでしょうか。

これらの土台を固めた上で、次の180日プランとして、Irregularが提唱するSOLVEのような客観的指標を用いたモデル評価基準の導入や、Upwindが取り組むクラウドランタイムの防御といった、より高度な運用の検討に進むのが現実的な道のりだと思います。

起業家向け:市場の「ど真ん中」を射抜く戦略

AIセキュリティという急成長市場は、起業家にとって大きなチャンスです。しかし、ただ技術的に優れたものを作るだけでは、この激しい競争を勝ち抜くことは難しいでしょう。

運用KPIで語れるプロダクトを

投資家は、もはや「すごいAI技術」だけでは動きません。Upwindが「アラートを90%削減」と具体的に訴求して1億ドルを調達したように、あなたのプロダクトが顧客の運用を「どれだけ楽にするか」を具体的な数字で語ることが重要です。誤検知率、インシデント対応時間(MTTR)の短縮率など、顧客の痛みに直結するKPIを初期から計測し、それを武器にすべきです。

プラットフォーム連携で導入障壁を壊す

どんなに優れた製品でも、導入が面倒であれば企業は二の足を踏みます。AegisAIが、Googleの元セキュリティ幹部によって設立され、Microsoft 365やGoogle WorkspaceとAPIで数分で統合できる手軽さを強みにしている点は、非常に示唆に富んでいます。既存の業務フローにシームレスに組み込める「導入の容易さ」は、それ自体が強力な競争優位性になるのです。

投資家向け:未来の価値を見抜くための視点

この市場に流れる73億ドル(2024年、前年比+52%)という巨額の資金は、投資家たちの高い期待を反映しています。しかし、その中から真の勝者を見抜くには、新しい評価軸が必要かもしれません。

「営業加速性」という新しいモノサシ

デューデリジェンスにおいて、技術の独自性はもちろん重要です。しかし、それ以上に「その製品が、顧客企業のビジネスプロセスやガバナンスを加速させるか?」という視点を持ってみてはどうでしょうか。例えば、Irregularのモデル評価は、単なるリスク対策ではなく、安全性を証明することで企業のAI導入の意思決定を早める「営業加速装置」としての価値を持ちます。このような、セキュリティ投資がコストではなくビジネスの推進力になる企業こそ、大きな成長が期待できるのではないでしょうか。

ポートフォリオを「TrustOpsスタック」で組む

人、データ、機械、モデル、クラウド。これらの領域は、もはや個別のセキュリティ課題ではありません。これらは相互に連携し、「信頼できるAI運用」という一つの大きなスタックを形成していくように私には見えます。だとすれば、投資戦略も、この「TrustOpsスタック」の各レイヤーをバランス良くカバーするポートフォリオを意識することが、長期的なリターンにつながるのかもしれません。

AIとセキュリティはまだ始まったばかり

AIセキュリティを巡るこの大きな物語は、まだ序章に過ぎないように思います。私たちが目の当たりにしているのは、AIという新しい力が社会に溶け込む過程で必然的に生まれる、新しい運用レイヤー、「TrustOps」の誕生です。

この変化は、一部の専門家だけのものではありません。ビジネスの現場でAIを使おうとするすべての人々、新しい価値を創造しようとする起業家、そして未来を形作ろうとする投資家、私たち全員に関わる大きな問いを投げかけています。

さて、あなたの組織における「信頼の運用」において、明日から踏み出すべき、具体的で、小さな、しかし決定的に重要な一歩は何でしょうか。この問いから、あなたの次の90日、そしてAIと共に歩む未来が始まるのかもしれません。

調査手法について

こちらの記事はデスクリサーチAIツール/エージェントのDeskrex.AIを使って作られています。DeskRexは市場調査のテーマに応じた幅広い項目のオートリサーチや、レポート生成ができるAIデスクリサーチツールです。

調査したいテーマの入力に応じて、AIが深堀りすべきキーワードや、広げるべき調査項目をレコメンドしながら、自動でリサーチを進めることができます。

また、ワンボタンで最新の100個以上のソースと20個以上の詳細な情報を調べもらい、レポートを生成してEmailに通知してくれる機能もあります。

ご利用をされたい方はこちらからお問い合わせください。

また、生成AI活用におけるLLMアプリ開発や新規事業のリサーチとコンサルティングも受け付けていますので、お困りの方はぜひお気軽にご相談ください。

市場調査やデスクリサーチの生成AIエージェントを作っています 仲間探し中 / Founder of AI Desk Research Agent @deskrex , https://deskrex.ai

コメント