はじめに

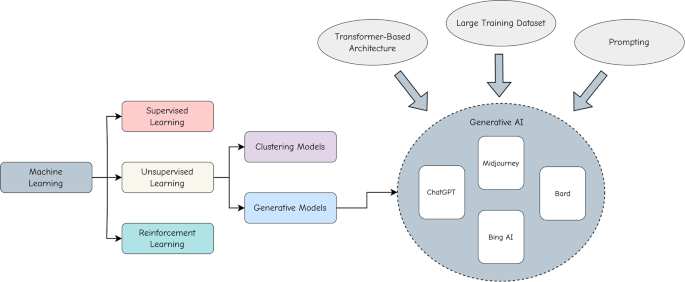

近年、人工知能(AI)技術の急速な発展に伴い、生成AI(Generative AI)が注目を集めています。生成AIは、大規模な言語モデルや画像生成モデルを用いて、人間のような自然な対話や高品質なコンテンツ生成を可能にする革新的な技術です。この生成AIが軍事分野に与えるインパクトは計り知れません。

従来の軍事におけるAIの活用は、主に情報収集や分析、意思決定支援などの領域に限定されていました。しかし、生成AIの登場により、その応用範囲は大幅に拡大しつつあります。生成AIは、戦闘シミュレーションや兵士の訓練、自律型兵器システムなど、軍事のあらゆる側面に革新をもたらす可能性を秘めているのです。

一方で、生成AIの軍事利用には、倫理的な課題も伴います。AIによる自律的な意思決定や兵器の制御は、人命に直結する重大な問題であり、慎重な議論と規制が必要とされています。透明性や説明責任の確保、国際法との整合性など、生成AIの軍事応用には乗り越えるべきハードルが存在するのです。

本記事では、米国防総省(DoD)におけるAIと生成AIの活用事例を中心に、軍事分野でのAIの可能性と課題について探ります。DoDは、生成AIタスクフォース「タスクフォース・リマ」を設立し、積極的に生成AI技術の導入を進めています。情報分析や意思決定支援、戦闘シミュレーション、兵士の訓練など、生成AIの活用は多岐にわたります。

また、ロボティクスの分野においても、生成AIとの融合が進んでいます。スタートアップ企業は大量の低コストロボットやAI分析ツールを制御することで、軍事作戦を変革しようとしています。

しかし、AI・生成AIの軍事応用には、倫理的な課題が付きまといます。AIの意思決定プロセスの透明性や、データバイアスの問題、自律型兵器の法的地位など、解決すべき問題は山積みです。DoD は、AIの倫理原則を定め、GREAT PLEA倫理ガイドラインの導入を検討するなど、責任ある生成AIの利用に向けて取り組みを進めています。

本記事では、これらの生成AIの軍事応用をめぐる最新の動向を詳しく解説します。AIと生成AIが軍事のパラダイムシフトを引き起こす中で、私たちは技術の可能性と倫理的な課題のバランスを探る必要があります。軍事とAI・生成AIの関係を理解することは、私たちの安全と平和を守るための鍵となるでしょう。

米軍における生成AIタスクフォースの設立

生成AIタスクフォース「タスクフォース・リマ」の設立と目的

DoDにおけるAI活用が進む中、生成AIの軍事応用に特化した部隊「タスクフォース・リマ」が2023年8月に設立されました。このタスクフォースは、生成AIの潜在的な可能性を評価し、安全かつ倫理的な利用方法を模索することを目的としています。

タスクフォース・リマの主な役割は、生成AIツールの評価と統合を進めることです。大規模言語モデルをはじめとする生成AIシステムを軍事分野で活用するための指針を策定し、各軍の導入を支援します。また、生成AIの応用研究を推進し、新たな利用ケースの発掘にも取り組みます。

タスクフォースは、180以上の利用ケースを収集し、生成AIの潜在的な可能性を評価しています。メールの要約や文書の自動生成など、実用的な応用が検討されているのです。一方で、重要な情報の欠落などのリスクも指摘されており、慎重な運用が求められます。

タスクフォース・リマは、18ヶ月の運営期間中に、政策提言やアーキテクチャガイダンスの策定を目指しています。これにより、DoDにおける生成AIの活用を促進し、効率的な業務運営を実現することが期待されているのです。

さらに、タスクフォース・リマは、生成AIの倫理的な利用に関するガイドラインの策定にも携わります。AIによる意思決定の透明性や説明責任の確保、プライバシーの保護など、生成AIの軍事利用に伴う倫理的な課題に対処するための枠組みづくりを進めるのです。

Scale AIとのパートナーシップによるAIモデルのテストと評価

生成AIの軍事利用を進めるにあたり、DoDはスタートアップ企業のScale AIとパートナーシップを結びました。Scale AIは、大規模言語モデルのテストと評価のための信頼性のある手段を提供することを目的としています。

Scale AIは、生成AIモデルのパフォーマンスを測定し、偏りや誤りを検出するためのツールを開発しています。これにより、軍事計画や意思決定を支援するAIシステムの安全性と信頼性を確保することが可能になります。また、戦闘員とのインタラクションを通じて、AIモデルの有用性を評価する仕組みも用意されています。

DoD内部の専門家を含む「ホールドアウトデータセット」を活用したテストにより、生成AIモデルが軍事アプリケーションに適しているかどうかを判断します。最終的には、モデルがテストされたドメインから逸脱し始めた場合にDoDの担当者に警告を発する仕組みの構築を目指しているのです。

Scale AIとの連携は、DoDが生成AIを安全かつ効果的に導入するための重要な一歩といえるでしょう。信頼性の高いテストと評価のプロセスを確立することで、生成AIの軍事利用に伴うリスクを最小限に抑えることができるのです。

タスクフォース・リマの設立とScale AIとのパートナーシップは、生成AIの軍事応用における米国の本気度を示すものといえます。DoDは、生成AIの可能性を最大限に引き出しつつ、倫理的な課題にも真摯に向き合おうとしているのです。

情報分析と意思決定支援における生成AIの役割

生成AIは、軍事分野における情報分析と意思決定支援に大きな変革をもたらしつつあります。リアルタイムの情報収集と迅速な意思決定を可能にする生成AIは、戦場における優位性を左右する重要な要素となっているのです。

リアルタイム情報収集と意思決定の迅速化

現代の戦闘では、膨大な情報を瞬時に処理し、適切な判断を下すことが求められます。生成AIは、リアルタイムで収集された情報を分析し、指揮官の意思決定を支援することができます。自然言語処理や画像認識、予測モデルなどの技術を駆使することで、生成AIは戦況の変化を即座に捉え、最適な行動を提案するのです。

例えば、衛星画像や偵察機からのデータをもとに、敵の動向を予測し、味方の部隊配置を最適化することが可能です。生成AIは、過去の戦闘データや兵器の性能、地形情報などを統合的に分析し、勝利の可能性を最大化する戦略を立案します。これにより、指揮官は短時間で的確な判断を下すことができ、戦場における優位性を確保することができるのです。

プロジェクト「Advana」によるデータ統合と分析

米国防総省(DoD)は、データ駆動型の意思決定を推進するためのC3 AIとのプロジェクト「Advana」を進めています。Advanaは、DoDが保有する膨大なデータを統合し、AIを活用した分析を可能にするプラットフォームです。

Advanaは、異なる組織間でのデータ共有を促進し、AIを含む先進的な分析ツールを提供します。これにより、DoDは情報のサイロ化を解消し、データの有効活用を図ることができます。Advanaは、兵器システムの予知保全や部隊の配備最適化、サプライチェーンの効率化など、幅広い分野での意思決定支援に役立てられています。

また、Advanaは、政策立案や予算配分の意思決定にも活用されています。生成AIを用いることで、複雑な政策オプションのシミュレーションや影響分析が可能になり、より合理的な意思決定を支援します。Advanaはまさに、DoDにおけるデータとAIの融合を象徴するプロジェクトといえるでしょう。

DARPAの信頼性の高いAI開発の取り組み

米国防高等研究計画局(DARPA)は、信頼性の高いAIシステムの開発を進めています。DARPAのプログラムの約70%で、AIや機械学習、自律技術が何らかの形で活用されているといいます。

DARPAが重視するのは、戦闘員が信頼できるAIシステムの開発です。生成AIを含むAI技術は、戦闘員の生命に直結する重要な判断を下す可能性があります。そのため、AIの意思決定プロセスの透明性や説明可能性を確保することが不可欠なのです。DARPAは、AIアルゴリズムの堅牢性や安全性、倫理性を担保するための研究を進めています。

また、DARPAは、産業界や学術界とのパートナーシップを通じて、最先端のAI技術の軍事応用を図っています。Google、Microsoft、OpenAI、Anthropicなどの企業と提携し、大規模言語モデルをはじめとする生成AI技術の活用を模索しているのです。

情報分析と意思決定支援における生成AIの役割は、今後ますます大きなものになるでしょう。リアルタイム情報処理と迅速な判断を可能にする生成AIは、戦場における勝敗を分ける決定的な要因となるかもしれません。DoDは、Advanaのようなデータ統合プラットフォームとDARPAの最先端AI研究を組み合わせることで、生成AIの軍事利用を加速させようとしているのです。

戦闘シミュレーションと兵士の訓練への応用

生成AIは、戦闘シミュレーションや兵士の訓練においても大きな可能性を秘めています。リアルな戦闘環境を再現し、兵士の能力を効果的に向上させることが期待されているのです。

OpenAIの生成AIを用いた戦闘計画の検証

米国陸軍研究所は、OpenAIの生成AIソリューションを用いて戦闘計画を検証する実験を行っています。この研究では、GPT-4 TurboおよびGPT-4 Visionモデルを使用して、シミュレーションされた戦場の地形データを収集し、友軍および敵軍の識別、攻撃および防御戦略に関する軍事的洞察を得ることを目的としています。

AIアシスタントは、敵軍を排除し、特定の目標地点を確保する任務を与えられ、さまざまな行動方針を生成しました。指揮官役のユーザーがこれらの方針を洗練させ、最適な戦略を導き出すのです。実験の結果、OpenAIのGPTモデルは他のモデルよりも優れた性能を示しましたが、任務目標を達成する過程でより多くの犠牲者を出すという課題も明らかになりました。

訓練の効率化とコスト削減

生成AIを活用することで、兵士の訓練をより効率的かつ低コストで行うことが可能になります。従来の訓練では、実際の装備や施設を用意する必要があり、多大な時間と費用がかかっていました。しかし、生成AIを用いてリアルなシミュレーション環境を構築することで、これらのコストを大幅に削減することができるのです。

生成AIは、過去の戦闘データを分析し、実戦さながらの状況を再現します。兵士は、バーチャルリアリティ(VR)技術を用いてこの環境に没入し、実践的な訓練を積むことができます。AIは兵士の行動を分析し、適切なフィードバックを与えることで、効果的なスキル向上を促します。また、シミュレーションを繰り返し行うことで、さまざまな戦術や状況への対応力を養うことができるのです。

米空軍のAIドッグファイトの成功事例

米空軍は、AIパイロットを搭載した実験機X-62Aを用いて、有人のF-16戦闘機との模擬空中戦(ドッグファイト)に成功しました。この実験は、DARPAの空戦進化(ACE)プログラムの一環として行われたものです。

X-62AとF-16は、時速1,200マイルで2,000フィートまで接近する「高アスペクトの鼻対鼻の接触」を行いました。X-62Aには安全のために人間のパイロットが搭乗していましたが、一度もAIシステムを無効にする必要はなかったといいます。この成功は、AIパイロットの実戦での活用可能性を示す重要なマイルストーンとなりました。

AIドッグファイトの成功は、AIが戦闘機パイロットの訓練にも応用できる可能性を示唆しています。AIを用いて、熟練パイロットの動きを学習し、リアルな対戦相手を生成することができるかもしれません。これにより、パイロットはより高度な戦術を磨き、実戦に備えることができるのです。

戦闘シミュレーションと兵士の訓練における生成AIの活用は、まさに軍事分野におけるゲームチェンジャーとなる可能性を秘めています。リアルな環境の再現、効率的なスキル向上、コスト削減など、生成AIがもたらす恩恵は計り知れません。 米国防総省(DoD)は、AIの軍事応用に大きな期待を寄せており、今後さらなる研究と実装が進むことでしょう。

スタートアップにおける軍隊ロボットとAIの活用

近年、ロボティクス技術の急速な発展に伴い、スタートアップにおいてもロボットとAIの活用が注目を集めています。特に、AIを搭載したロボットやAIによる軍事のスタートアップは、情報収集や監視、偵察などの任務において大きな可能性を秘めているのです。

Swarmboticsの低コストロボット大量展開戦略

スタートアップ企業Swarmboticsは、低コストのロボットを大量に展開することで、軍事作戦を変革しようとしています。同社は、小型の自律走行ロボット「Fire ANT」や大型の自律ATVロボット「Haul ANT」などのプラットフォームを開発しました。これらのロボットは、情報収集、監視、電子戦、医療搬送など、さまざまな用途に対応可能です。

Swarmboticsの戦略の特徴は、高性能なセンサーを追求するのではなく、コストパフォーマンスを重視した設計にあります。安価なロボットを大量に投入することで、より広範囲をカバーし、冗長性を確保することができるのです。また、ロボットの損失が発生した場合でも、容易に代替機を投入できるため、ミッションの継続性を維持できます。

Swarmboticsは、米国防総省(DoD)のニーズに応じた柔軟性と相互運用性を重視しています。同社は、Quiet Capital、Silent Ventures、LMNT Venturesなどから400万ドル以上の資金を調達しており、DoD調達担当者に向けて技術を提供しつつ、将来的には商業企業への販売も計画しているといいます。

情報収集や監視におけるスウォームロボットの活用

AIを搭載したスウォームロボットは、情報収集や監視の分野で大きな威力を発揮します。スウォームロボットとは、多数の小型ロボットが協調して行動する群ロボットシステムのことです。個々のロボットは比較的シンプルな機能しか持ちませんが、集団で連携することで高度なタスクを遂行できるのが特徴です。

スウォームロボットは、広大な地域を効率的に探索し、情報を収集することができます。各ロボットがセンサーで収集したデータを共有し、全体としての状況認識を構築するのです。例えば、災害現場や敵地域など、人間が立ち入ることが困難な環境下での情報収集に威力を発揮します。

また、スウォームロボットは、ターゲットの追跡や監視にも活用できます。複数のロボットが協調して対象を追尾することで、より確実な監視が可能になります。ロボット同士が通信を行い、ターゲットの位置情報を共有しながら、最適な追跡ルートを計算するのです。

Defcon AIの軍事環境向けの分析(MS&A)ツールセット

DEFCON AIは、ビッグデータと最先端技術を活用し、国の緊急課題に対処するためのソリューションを構築しています。調達した資金は、チームの拡大や研究開発プログラムの強化、デュアルユース製品の拡充に使用される予定です。特に、数学的最適化技術とAIを組み合わせたソフトウェアを提供し、計画者が不完全な情報でも迅速にシナリオを開発できるシミュレーション機能を実現しています。また、DEFCON AIは米国防総省(DoD)との契約を通じて、物流の最適化を図っています。

DEFCON AIは、次世代の物流およびモビリティワークフローのための技術ソリューションを提供し、国防および商業アプリケーションにおける対応計画を進化させています。4400万ドルのシード資金調達により、同社は防衛ミッションや商業セクターにおけるコア機能の拡張を進め、軍事戦略の革新を加速させることが期待されています。これにより、DEFCON AIは防衛技術の革新に寄与し、次の主要なDoDのプライム契約者になる可能性を秘めています。

国防総省との連携の検討

スウォームロボットやDEFCON AIの軍事活用は、国防総省にとっても大きな関心事となっています。DoDは、ロボティクスやAIの融合による新たな戦術の可能性を模索しており、SwarmboticsやDEFCON AIのようなスタートアップ企業との連携を検討しているといわれています。

DoDは、ロボットスウォームの実証実験や、AIを用いた自律制御アルゴリズムの開発などに注力しています。また、スウォームロボットの運用に関する doctrine(基本原則)の策定や、法的・倫理的な課題の検討も進められているようです。

軍事におけるロボットとAIの活用は、まだ発展途上の段階にありますが、その可能性は計り知れません。低コストで大量展開可能なスウォームロボットと、高度な自律性を実現するAIの組み合わせは、軍事作戦のパラダイムシフトを引き起こすかもしれません。 技術的な課題や倫理的な議論はまだ残されていますが、ロボティクスとAIの融合が軍事の未来を大きく変える可能性は高いと言えるでしょう。

生成AIの倫理的課題と利用ガイドライン

生成AIの軍事利用は、大きな可能性を秘めている一方で、重大な倫理的課題も抱えています。AIによる自律的な意思決定や兵器の制御は、人命に直結する問題であり、慎重な議論と規制が不可欠です。

透明性、信頼性、公平性などの倫理原則

生成AIの軍事利用において、透明性、信頼性、公平性は特に重要な倫理原則となります。AIシステムがどのように意思決定を行っているのか、その過程が透明であることが求められます。ブラックボックス化したAIでは、予期せぬ判断を下すリスクがあるからです。

また、AIシステムの信頼性を担保することが不可欠です。軍事的な意思決定は、兵士の生死に直結する重大な問題です。AIの判断が常に信頼に足るものであることを保証する必要があるのです。さらに、AIシステムが特定の属性や集団に対して不公平な判断を下さないよう、公平性の確保も重要です。

致死的自律兵器におけるAIの使用をめぐる議論

生成AIの軍事利用における最も深刻な倫理的課題は、致死的自律兵器システム(LAWS)における使用をめぐる議論です。LAWSとは、人間の関与なしに攻撃目標を選定し、攻撃を行うことができる兵器システムのことを指します。

LAWSの開発と使用については、国際的に大きな懸念が示されています。AIが自律的に致死的な力を行使することは、人道的観点から大きな問題があるとされているのです。また、LAWSが誤作動した場合や、ハッキングされた場合の危険性も指摘されています。

一方で、LAWSの開発を推進する立場からは、人間の判断ミスによる被害を減らせるという主張もあります。AIによる高速な情報処理と正確なターゲティングは、民間人の犠牲を最小限に抑えられるというわけです。ただし、この主張に対しては、AIの判断の信頼性や倫理性に関する反論も根強くあります。

DODのAI倫理原則と責任ある利用の重要性

米国防総省(DoD)は、2020年にAI倫理原則を発表し、AIの責任ある利用を推進しています。この原則では、AIシステムが合法性、倫理性、正当性を備えていること、意図したとおりに機能すること、適切な水準の判断を行うことなどが求められています。

また、DoDは、AIの意思決定プロセスの透明性と説明可能性を重視しています。AIがなぜそのような判断を下したのか、人間が理解できる形で説明できることが必要だというわけです。さらに、AIシステムに対する人間の監督と制御可能性も重要視されています。

DoDは現在、これらの倫理原則に基づいて、生成AIの軍事利用に関するガイドラインの策定を進めています。責任ある利用を確保するための体制づくりは、生成AI活用における喫緊の課題といえるでしょう。

GREAT PLEA倫理原則の提案

軍事分野におけるAIの倫理的利用を確保するために、「GREAT PLEA」と呼ばれる新たな倫理原則が提案されています。これは、軍事と医療の分野で共通する倫理的課題に対処するためのフレームワークです。

GREAT PLEAは、以下の9つの原則から構成されています:

- Governability(統治可能性)

- Reliability(信頼性)

- Equity(公平性)

- Accountability(説明責任)

- Traceability(追跡可能性)

- Privacy(プライバシー)

- Lawfulness(合法性)

- Empathy(共感)

- Autonomy(自律性)

GREAT PLEA原則は、生成AIの軍事利用における倫理的ジレンマに対処するための指針として期待されています。各原則を実践的に適用することで、生成AIの恩恵を最大限に引き出しつつ、倫理的リスクを最小限に抑えることができるというわけです。

生成AIの軍事利用は、技術的な可能性と倫理的な課題のはざまにあります。私たちは、生成AIのポテンシャルを活かしつつ、人間の尊厳と価値を守るためのバランスを探る必要があります。透明性、信頼性、公平性といった普遍的な倫理原則と、軍事分野固有の課題に対処するためのガイドラインの策定が急務といえるでしょう。

オープンソースAIモデルの活用と課題

生成AIの軍事利用において、オープンソースのAIモデルが果たす役割が注目されています。オープンソースモデルは、その透明性と利用可能性から、軍事分野におけるAIの民主化を促進する可能性を秘めているのです。

オープンファウンデーションモデルの利点とリスク

オープンファウンデーションモデルとは、そのアーキテクチャやパラメータが公開され、ユーザーによって検査、修正、運用が可能なAIモデルのことを指します。 GPT-4のような大規模言語モデル(LLM)の登場により、オープンソースのLLMが軍事分野でも活用されるようになりました。

オープンモデルの利点は、迅速な技術革新、公共の透明性、サイバーセキュリティの強化などが挙げられます。オープンな開発プロセスは、多様なステークホルダーの参加を促し、イノベーションを加速します。また、モデルの動作が透明であることで、説明責任の確保や倫理的な検証が可能になります。さらに、オープンソースコミュニティによる脆弱性の発見と修正は、AIシステムのセキュリティ向上につながるのです。

一方で、オープンモデルには悪用のリスクも存在します。公開されたモデルを悪意のあるユーザーが利用し、サイバー攻撃や偽情報の拡散、違法行為の実行などに用いる可能性があるのです。また、オープンソースのAIモデルが、テロリストや敵対勢力の手に渡るリスクも懸念されています。

これらのリスクと利点のバランスをどう取るかは、難しい課題です。適切な規制とガバナンスの枠組みを設けつつ、オープンモデルの潜在的な恩恵を最大限に引き出すことが求められるでしょう。

DODのAI戦略とオープンモデルの導入

米国防総省(DoD)は、AIシステムの調達において、オープンファウンデーションモデルの活用を推進しています。オープンモデルは、低コストで高い柔軟性を持つため、軍事用途に適しているとされるのです。特に、エッジコンピューティングや組み込みシステムなど、リソースに制約のある環境では、オープンモデルが力を発揮します。

DoDは、2023年に発表された「国家安全保障のためのオープンソースソフトウェア戦略」の中で、オープンソースの重要性を明確に打ち出しました。この戦略では、オープンソースソフトウェアの採用を加速し、サプライチェーンのセキュリティを強化することが目標とされています。生成AIの分野でも、オープンモデルの活用が推奨されているのです。

また、DoDは、AIの責任ある開発と利用を推進するために、AIライフサイクル管理フレームワーク(CALM)を策定しました。CALMは、AIシステムの設計、開発、展開、運用、廃棄までのライフサイクル全体を通じて、倫理的・法的・社会的な影響を評価・管理するための枠組みです。オープンソースモデルの導入においても、CALMに基づいたガバナンスが求められます。

供給者の多様性と競争力の確保

オープンファウンデーションモデルの採用は、AIシステムの供給者の多様性と競争力の確保にも寄与します。独占的な企業に依存するのではなく、オープンなエコシステムを構築することで、イノベーションを促進し、コストを削減できるのです。

また、オープンモデルは、中小企業やスタートアップにも参入の機会を与えます。多様なプレイヤーが市場に参加することで、DoDは最先端の技術を柔軟に調達できるようになります。これは、軍事におけるAIの民主化とも言えるでしょう。

ただし、オープンソースの活用には、サプライチェーンのセキュリティ確保が不可欠です。悪意のあるコードの混入や、脆弱性の悪用を防ぐための体制づくりが求められます。DoDは、オープンソースの利点を最大限に引き出しつつ、セキュリティリスクを適切に管理する必要があるのです。

オープンソースAIモデルの軍事利用は、技術的な可能性と社会的な影響が交錯する複雑な問題です。透明性、イノベーション、セキュリティのバランスを取りながら、オープンモデルの潜在力を引き出していくことが重要でしょう。DoDがオープンソースの価値を認識し、積極的な導入を進めていることは、軍事におけるAIの未来を示唆するものといえます。

おわりに

本稿では、AI・生成AIが米国軍隊にもたらしつつある変革について、幅広い観点から考察してきました。情報分析と意思決定支援、戦闘シミュレーションと訓練、ロボティクスなど、AI・生成AIの軍事応用は多岐にわたります。米国防総省(DoD)は、AI・生成AIの潜在力を活かすべく、タスクフォース・リマを設立し、積極的な導入を進めているのです。

AI・生成AIが軍事分野に与える変革のまとめ

AI・生成AIは、軍事分野のあらゆる側面に変革をもたらしつつあります。情報収集と分析の効率化、意思決定の迅速化、リアルな戦闘シミュレーション、兵士の訓練の高度化など、その影響は計り知れません。また、ロボットスウォームと生成AIの融合は、新たな軍事ドクトリンを生み出す可能性を秘めています。

これらの変革は、軍事作戦の効率を飛躍的に高め、人的リソースの節約と迅速な対応を可能にします。生成AIは、指揮官の意思決定を支援し、兵士の生存率を高めることで、戦場における優位性をもたらすのです。さらに、サイバー脅威や偽情報への対抗、敵の行動予測など、新たな脅威への対応力も強化されるでしょう。

倫理的な利用と技術発展のバランスの重要性

AI・生成AIの軍事利用は、大きな可能性とともに、重大な倫理的課題をはらんでいます。AIによる自律的な意思決定や兵器の制御は、人命に直結する問題であり、慎重な議論と規制が不可欠です。特に、致死的自律兵器の開発と使用をめぐっては、国際社会が懸念を共有しています。

DoDは、AI・生成AIの軍事利用に関する倫理原則を策定し、GREAT PLEA倫理ガイドラインの導入を検討するなど、責任ある利用の確保に向けた取り組みを進めています。透明性、信頼性、公平性といった普遍的な価値観を守りつつ、軍事の特殊性に対応したルールづくりが求められるのです。

また、オープンソースAIモデルの活用は、イノベーションと民主化を促進する一方で、悪用のリスクも伴います。技術の進歩と倫理的な配慮のバランスを取ることが、健全な軍事AIの発展には欠かせません。

継続的な議論と政策形成の必要性

軍事分野におけるAI・生成AIの利用は、国防だけでなく、社会全体に大きな影響を及ぼします。AIの軍拡競争や、プライバシー・市民的自由への脅威など、技術の進歩に伴う負の側面にも目を向ける必要があります。軍事と民生の垣根が曖昧になる中で、AIの影響を見据えた社会的な議論が不可欠なのです。

DoDは、軍事AIの発展に伴う社会的リスクを適切に管理する責務を負っています。技術の進歩に見合ったガバナンスの仕組みづくりには、政府、産業界、学術界、市民社会の協力が欠かせません。生成AIの軍事利用をめぐる継続的な対話と、バランスの取れた政策形成が求められているのです。

AI・生成AIは、軍事のパラダイムシフトを引き起こしつつあります。その変革の行方は、技術的な可能性と倫理的な課題のはざまで決まります。米国防総省のタスクフォース・リマの取り組みは、その難しいバランス探しの一歩といえるでしょう。軍事と生成AIの関係を適切に導いていくことは、より安全で平和な世界の構築につながります。技術と倫理、国防と社会の対話を深め、英知を結集することが、いま私たちに問われているのです。

調査手法について

こちらの記事はデスクリサーチAIツール/エージェントのDeskrex.AIを使って作られています。DeskRexは市場調査のテーマに応じた幅広い項目のオートリサーチや、レポート生成ができるAIデスクリサーチツールです。

調査したいテーマの入力に応じて、AIが深堀りすべきキーワードや、広げるべき調査項目をレコメンドしながら、自動でリサーチを進めることができます。

また、ワンボタンで最新の100個以上のソースと20個以上の詳細な情報を調べもらい、レポートを生成してEmailに通知してくれる機能もあります。

ご利用をされたい方はこちらからお問い合わせください。

また、生成AI活用におけるLLMアプリ開発や新規事業のリサーチとコンサルティングも受け付けていますので、お困りの方はぜひお気軽にご相談ください。

市場調査やデスクリサーチの生成AIエージェントを作っています 仲間探し中 / Founder of AI Desk Research Agent @deskrex , https://deskrex.ai

コメント